本文共2181字

AI晶片龍頭輝達(NVIDIA)推出全新AI產品「HGX H200」,主打超高容量與更大的頻寬,算力更為精進,預計今(2024)年第2季開始出貨,其中,採用高頻寬記憶體(HBM)「HBM3e」更是讓外界眼睛一亮 ,預期將再掀起一波AI熱潮。對此,《經濟日報》整理相關資訊,供讀者參考比較。

NVIDIA 這次推出新品來頭可不小,最新 HGX H200 處理器配備 H200 Tensor Core GPU,並具有先進的記憶體(HBM),可為生成式AI與高效能運算(HPC)的工作負載處理大量資料。

亮點一 :號稱「地表強AI晶片」有影?

隨著產品發表,不少人稱 H200 是地表最強晶片,根據 NVIDIA 說明, HGX H200配備 H200 Tensor Core GPU,並具有先進的記憶體,可為生成式AI與高效能運算(HPC)的工作負載處理大量資料。

H200與前代產品 H100相比,在 Llama 2 這樣擁有700億參數大型語言模型(LLM)實測中,推論速度將近翻倍提升。而 H100 是 OpenAI 用於訓練其最先進的大型語言模型 (LLM) GPT-4 的晶片, H200的推出無疑能大幅提升AI訓練程度。

此外,與前一代產品 A100 相比,容量幾乎翻倍,頻寬增加2.4倍,可部署在各種類型的資料中心中,包括本地、雲端、混合雲和邊緣環境等。

亮點二: HBM3E 將讓 NVIDIA 封神?

NVIDIA 此次推出 H200,是首款提供 HBM3e 規格的 GPU,可加速生成式AI和大型語言模型,並能推進 HPC 工作負載的科學運算,以每秒4.8 TB 速度提供141GB 記憶體。

據我們所知,不管是伺服器廠商業或是雲端業者、AI模型,追求的不只要有更高規格的AI晶片,還要求更棒的算力,此時,就需要更有效能、更複雜的記憶體,而這項產品就是 HBM。

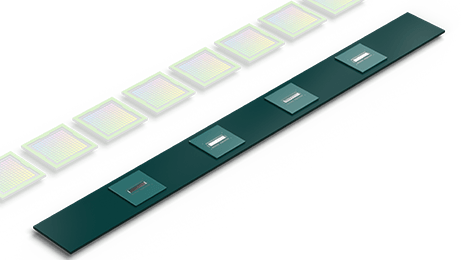

HBM(High Bandwidth Memory )中文名稱為高頻寬記憶體,簡單來說,是一種藉由封裝技術堆疊多層 DRAM,以此降低體積並增加儲存空間、功率的記憶體。

同時,根據全球第三大 DRAM 廠美光執行長梅羅塔表示,美光的 HBM3E 已能做到每個八層 DRAM 堆疊高頻寬記憶體,厚度僅為人類頭髮的一半,頻寬可達24GB。(延伸閱讀:美光:AI讓記憶體潛力無窮 台中四廠將領先全球量產高頻寬晶片)

根據美光對 HBM3E 說法, HBM3E 增加的記憶體頻寬可改善系統層級的效能,將訓練時間縮短,與上一代的 HBM3 比起來,在技術上可說是一大突破,台灣則是美光 HBM3E 產品的首發量產地,預期2024年Q1就會量產,但還不確定何時出貨。

亮點三: H200 2024Q2出貨 台供應商受惠?

NVIDIA 指出,H200軟硬體皆與 HGX 100系統相容,也可與去(2023)年8月推出、採用 HBM3e 的 GH200 Grace Hopper 超級晶片模組搭配使用。對此,伺服器生態系合作夥伴,包括華碩(2357)、技嘉、雲達、緯創、緯穎、美超微、永擎電子、慧與、戴爾、聯想、鴻佰、Eviden 等,都可使用基於 H200的直接替換方式來更新其基於 H100的系統。

同時,亞馬遜網路服務、Google Cloud、微軟 Azure 和 Oracle Cloud Infrastructure 也將成為第一批部署基於 H200 執行個體的雲端服務供應商。

另外,美光成配合 NVIDIA 在 HBM3E上的供應,屆時華邦(2344)、鈺創、晶豪科、愛普等記憶體台廠也有望受惠。

亮點四: AMD與 NVIDIA 將要正面對決?

雖然 NVIDIA 的 HGX H200在技術上取得突破,不過, AMD 執行長蘇姿丰去(2023)年6月發表 GPU 產品 MI300X,除了號稱提供的 HBM 密度是 NVIDIA H100 的2.4倍,HBM 頻寬是 H100 的1.6倍外。MI300X 擁有1530億個電晶體,具有12個5nm 小晶片,並高達192GB HBM3 記憶體。

相較之下, H200在記憶體部分,仍與 AMD 的 GPU 有一段不小落差,不過, NVIDIA 也利用自家獨門技術 NVLink 與 NVSwitch,提高運算速度,在彌補記憶體容量不足之虞,更加強運算效力。

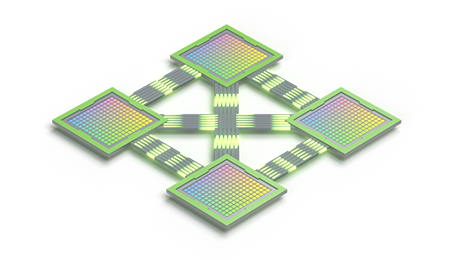

根據 NVIDIA 官網說明, NVLink 是一項 GPU 至 GPU 的直接互連技術,可在伺服器內擴充多 GPU 的輸入/輸出 。再與 NVSwitch 整合,連接多個 NVLink,可在單一節點與多節點間以 NVLink 全速提供全方位 GPU 通訊。

NVSwitch 可讓 NVLink 連線跨節點延伸,並建立流暢且高頻寬的多節點 GPU 叢集,有效將 GPU 擴充至資料中心適用大小。 NVIDIA 進一步說明指出,在伺服器外新增第二層 NVSwitch 後,NVLink 網路便可連接高達 256 個 GPU,並以每秒 57.6 TB (TB/秒) 的驚人速度提供全頻寬 。

(資料來源:記者鐘惠玲、李孟珊)

延伸閱讀

VIP》有 Nvidia H200 加速 美科技股將再掀 AI 狂潮

Nvidia 升級 AI 處理器推 H200 強化領先 AMD 和英特爾優勢

※ 歡迎用「轉貼」或「分享」的方式轉傳文章連結;未經授權,請勿複製轉貼文章內容

留言