本文共761字

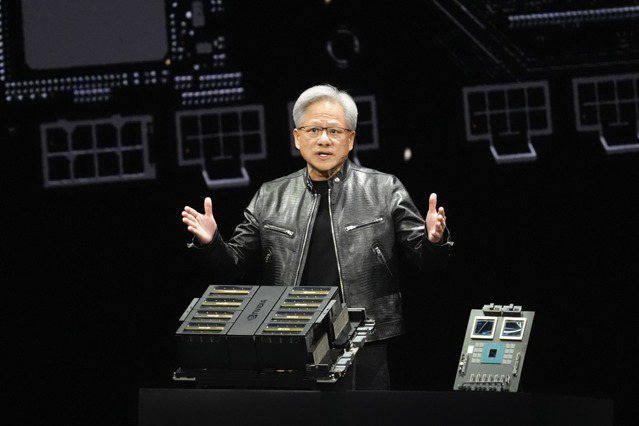

輝達(NVIDIA)身為當前的AI霸主,28日宣布該公司在業界標準測試中提供了世界上最快的生成式AI推論平台。

在最新的MLPerf基準測試中,NVIDIA TensorRT-LLM這個可加速和簡化大型語言模型複雜推論工作的軟體,將GPT-J LLM上的NVIDIA Hopper架構GPU效能較六個月前提高近3倍。

在輝達H200 Tensor核心GPU上運行的TensorRT-LLM,在MLPerf 迄今為止最大規模的生成式AI測試中,提供最快的運行推論效能。

新的基準測試使用Llama 2的最大版本,Llama 2是最先進的大型語言模型,包含700億個參數。該模型比9月基準測試中首次使用的GPT-J大型語言模型大10倍以上。

記憶體增強型H200 GPU在MLPerf首次亮相時,使用TensorRT-LLM每秒產生高達31,000個詞元,創下MLPerf的Llama 2基準測試紀錄。

輝達指出,現在已提供 H200 GPU供客戶測試,並將於第2季出貨。H200 GPU很快將由近20家系統製造商和雲端服務供應商提供。H200 GPU包含141GB高頻寬記憶體HBM3e,與H100 GPU相比,記憶體增加76%,運行速度提高43%。

輝達表示,Hopper GPU 在最新一輪MLPerf產業基準測試中,橫掃了所有AI推論測試。MLPerf的測試透明且客觀,因此使用者可以依靠結果做出明智的購買決定。而輝達的合作夥伴參與 MLPerf ,是因為他們知道這對客戶評估AI系統和服務來說是一個很有價值的工具。

這次在NVIDIA AI平台上提交結果的合作夥伴,包括華碩(2357)、思科、戴爾、富士通、技嘉(2376)、Google、慧與科技、聯想、微軟Azure、甲骨文、雲達科技、美超微、VMware和緯穎(6669)。

※ 歡迎用「轉貼」或「分享」的方式轉傳文章連結;未經授權,請勿複製轉貼文章內容

留言