本文共1666字

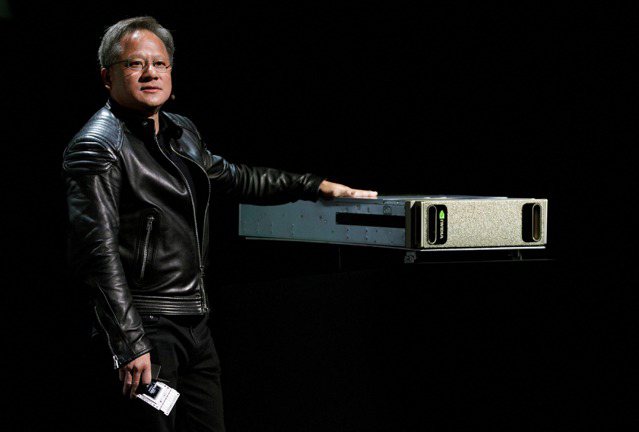

一年一度的Nvidia GTC大會於3月下旬盛大展開,創辦人暨執行長黃仁勳宣布,AI的iPhone時刻已經開始,AI話題再度成為市場矚目焦點。不僅如此,正值歐美銀行陸續傳出危機並帶動全球資金往債市靠攏下,一些具有AI題材或概念的個股此刻也成為資金的避風港。

到底ChatGPT所帶動的生成式AI風潮是否會像前一波話題元宇宙(Metaverse)只是短期的題材?抑或是下一場生產力革命的開始?套一句以色列新創公司Deci創辦人Yonatan Geifman所述:「我們正處於這場生成式AI革命的開端,你永遠不能低估你在這場革命周期中的位置。這有點像當初網際網路剛出現時一樣。」

持平而言,除了目前寡占全球生成式AI的GPU晶片大廠Nvidia,於今年將有1%以內的生成式AI營收的貢獻,且三年內有提升至10%以上的潛力外,大部分個股可能短期皆以題材居多。儘管如此,我們見到ChatGPT充分發揮人工智慧結合自然語言模型聊天機器人的驚人潛力,繼OpenAI於去年11月推出的ChatGPT-3才爆紅三個半月,今年3月中旬再度推出的ChatGPT-4,已較前一代的對話能力暴增八倍,並從3,000個單詞增加至一次可處理25,000個單詞。生成式AI等比級數的發展速度遠超過半導體的摩爾定律,帶動市場熱度已從終端消費者的直接感受,一路影響到產業界如何把握機會或克服挑戰、以及企業界如何看待相關趨勢並讓應用盡快落地的境地。

儘管全球各大雲端服務商受限產業景氣下行、消費性電子需求降溫,導致資本支出下修並使雲端/資料中心今年的建置速度放緩,惟在AI風潮再度席捲全球下,這些科技大廠也都轉而積極加速打造各項生成式AI的各項應用,使得今年成為生成式AI軍備競賽的元年。為了有效運用算力達成AI應用目標,全球超大規模資料中心勢必增加雲端/資料中心的建置,連帶推升AI伺服器與400G交換器的需求,同時也會帶動邊緣裝置的銷售。

根據統計,以微軟將ChatGPT整合至Bing搜尋引擎需要花費40億美元的資本支出來建置Nvidia的DGX系統,才能在1秒以內回答使用者一個問題。如果以Google每天需要處理80~90億次的查詢,其將需耗費800億美元的資本支出在Nvidia的DGX系統,才能有現今ChatGPT的應對速度與能力。

根據統計,在AI伺服器當中,半導體的內涵價值較一般伺服器高出十倍以上,關鍵半導體原件除了GPU之外,就屬先進封裝,連帶推升高頻寬記憶體、ABF載板、測試介面等潛在商機。由於GPU運用在AI運算的關鍵在於記憶體的頻寬,在訓練百億或千億的參數需要很高的運算能力,一般DRAM受限於低頻寬的問題而難以負荷,因此業界目前均採用先進封裝技術將GPU與高頻寬記憶體整合在一起進行封裝。晶圓代工龍頭日前推出3D Fabric先進封裝平台,整合旗下CoWoS與InFo等封裝技術與SoIC堆疊技術,裏頭涵蓋EDA、IP、高頻寬記憶體、封裝、載板、測試等,可望順利承接生成式AI所帶動的先進封裝商機。

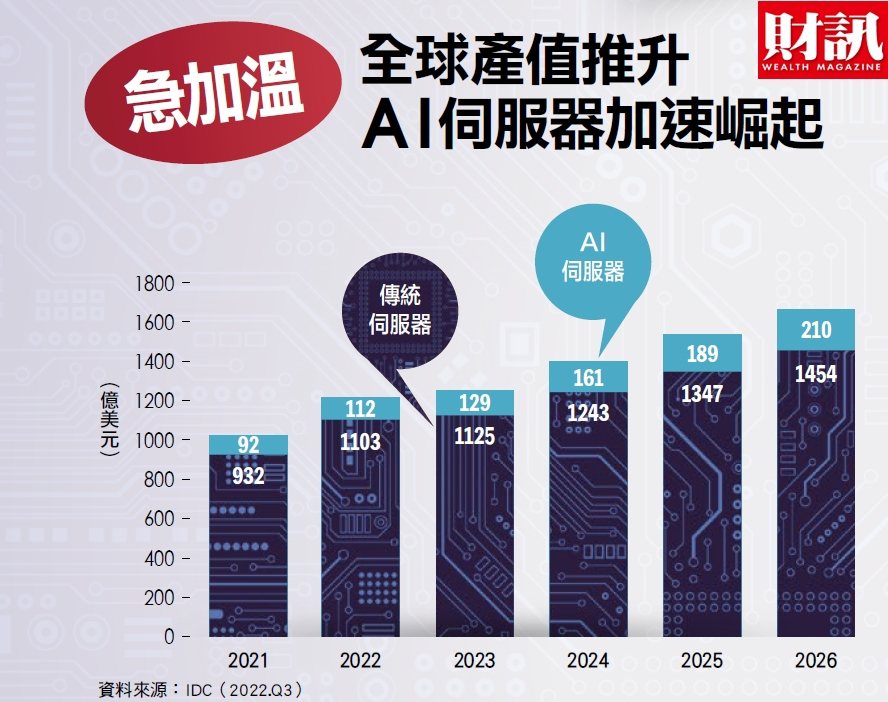

除此,AI伺服器需要更具效能的運算能力、更強大的頻寬傳輸、更好的散熱效果、更大的記憶體儲存容量,支撐高階AI伺服器的平均售價較一般伺服器高出三倍以上。根據研究機構IDC報告分析,硬體占AI支出比重約50%,其中伺服器更占硬體支出比重的80%以上,因此AI伺服器將是半導體族群之外,最受惠升成式AI趨勢的族群。

AI伺服器較一般伺服器需採用更多的CPU與GPU,使伺服器產生更多的熱能,Intel的Sapphire Rapids與AMD的Genoa CPU熱設計功耗(TDP)約350~400瓦,而每一顆GPU(A100/H100)將額外產生300~700瓦的熱能,此將使散熱與電源供應的規格提升,可望推升相關業者長期的產品均價與毛利率。

記憶體而言,高階AI伺服器所需DRAM容量是一般伺服器的八倍、NAND容量則是一般伺服器的三倍。我們預估AI伺服器將對今年DRAM整體需求貢獻0.6個百分點,未來幾年將提升至2.8個百分點。

(作者是凱基投顧董事長)

※ 歡迎用「轉貼」或「分享」的方式轉傳文章連結;未經授權,請勿複製轉貼文章內容

留言