本文共1179字

輝達(NVIDIA)新一代平台Blackwell,包含B系列GPU及整合NVIDIA自家Grace Arm CPU的GB200等。研調機構集邦科技(TrendForce)指出,GB200的前一代為GH200,皆為CPU+GPU方案,主要搭載NVIDIA Grace CPU及H200 GPU,但以GH200而言,出貨量估僅占整體NVIDIA高階GPU約5%。

目前供應鏈對NVIDIA GB200寄予厚望,預估2025年出貨量有機會突破百萬顆,占NVIDIA高階GPU近4~5成。

不過,NVIDIA雖計畫在今年下半年推出GB200及B100等產品,但上游晶圓封裝方面須進一步採用更複雜高精度需求的CoWoS-L技術,驗證測試過程將較為耗時。此外,針對AI伺服器整機系統,B系列也需耗費更多時間優化,如網通、散熱的運轉效能,預期GB200及B100等產品要等到今年第4季,至2025年第1季較有機會正式放量。

CoWoS方面,由於NVIDIA的B系列包含GB200、B100、B200等將耗費更多CoWoS產能,台積電(2330)亦提升2024全年CoWoS產能需求,預估至年底每月產能將逼40k,相較2023年總產能提升逾150%;2025年規劃總產能量有機會幾近倍增,其中NVIDIA需求占比將逾半數。

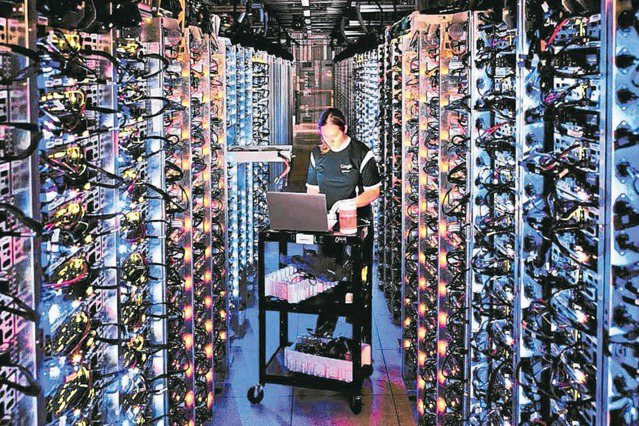

而Amkor、Intel等目前主力技術尚為CoWoS-S,主攻NVIDIA H系列,短期內技術較難突破,故近期擴產計畫較為保守,除非未來能夠拿下更多NVIDIA以外的訂單,如雲端服務業者(CSP)自研ASIC晶片,擴產態度才可能轉為積極。

HBM方面,從NVIDIA及超微(AMD)近期主力GPU產品進程及搭載HBM規格規劃變化來看,TrendForce認為2024年後將有三大趨勢。其一,「HBM3進階到HBM3e」,預期NVIDIA將於今年下半年開始擴大出貨搭載HBM3e的H200,取代H100成為主流,隨後GB200及B100等亦將採HBM3e。AMD則規劃年底前推出MI350新品,期間可能嘗試先推MI32x等過度型產品,與H200相抗衡,均採HBM3e。

其二,「HBM搭載容量持續擴增」,為了提升AI伺服器整體運算效能及系統頻寬,將由目前市場主要採用的NVIDIA H100(80GB),至2024年底後將提升往192~288GB容量發展;AMD亦從原MI300A僅搭載128GB,GPU新品搭載HBM容量亦將達288GB。

其三,「搭載HBM3e的GPU產品線,將從8hi往12hi發展」,NVIDIA的B100、GB200主要搭載8hi HBM3e,達192GB,2025年則將推出B200,搭載12hi HBM3e,達288GB;AMD將於今年底推出的MI350或2025年推出的MI375系列,預計均會搭載12hi HBM3e,達288GB。

※ 歡迎用「轉貼」或「分享」的方式轉傳文章連結;未經授權,請勿複製轉貼文章內容

留言